Bronnen bij Methodes, begrippen: algoritmesInleiding De wereld wordt geregeerd of beter geterroriseerd door alfa's, die alles wat van de bèta-kant komt wantrouwt tot op het botEn terecht, die afkeer: de ratio en hang naar de werkelijkheid is een dodelijk gevaar voor de oneindige stroom taalmanipulatie en leugens die de alfa's gebruiken om hun dominantie te bestendigen. De verbale terreur die je tegemoet komt als je een krant opslaat of de televisie aanzet als het over sociaal-maatschappelijke zaken gaat. "De politiek", en dergelijke. Volkswijsheid: "Wanneer liegt een politicus? Antwoord: wanneer hij zijn mond opendoet". Zijnde een specifiek geval van "Wanneer liegt de alfa-intellectuele elite in bestuur en media? Antwoord: Wanneer ze hun mond opendoen". Die oneindige stroom taalmanipulatie en leugens en dus verbale terreur zijn noodzakelijk door een algemeen menselijke geesteszwakte, die bij alfa's bijna altijd dodelijk toeslaat: de behoefte in de vastigheden en absoluutheden van de ideologie Hier betreft die terreur de laatste ontwikkeling in de informatietechnologie: het algoritme. Nu wordt in de ICT zelf de term "algoritme" algemeen gebruikt voor een combinatie van computeropdrachten die een bepaalde functie of regel uitvoeren, meestal op wat ingewikkelder niveau. In de maatschappelijke discussie gaat het over de hogere versies, die verbanden tussen databestanden onderzoeken. Eigenlijk doodgewoon als verlenging van de statistiek. In de statistiek hebben de statistici, vrijwel altijd sociologen, een dikke vinger in de pap van wat de uitkomsten worden, vooral door de keuze van onderwerp (alles aangaande ras en aangaande intelligentie is verboden), de keuze van vragen, en de keuze van publiek De algoritmes die daarnaast gebruikt zijn gaan worden kunnen veel grotere databestanden aan, bestanden die niet gebaseerd zijn op het stellen van vragen aan bepaalde mensen maar gewoon via ongerelateerde manieren zijn verzameld, het zogenaamde data-mining Vroeger vroeg de controleur of de onderzoeker aan iemand met een uitkering wat ze hadden uitgegeven, met databestanden kan je het bestand van uitkeringsgerechtigden koppelen aan het bestand van autobezitters via het kentekenregister, en zo de fraudeurs met duurdere auto's eruit halen (criminelen vroegen nogal eens een uitkering aan om niet op te vallen als crimineel). Maar zelfs dit verband is ingewikkelder dan het lijkt zodra je geleidelijke grenzen moet gebruiken en meer factoren mee moet nemen. In de tweede fase van ontwikkeling van dit soort algoritmes kwamen wat heet "neurale netwerken", die dus enigszins lijken op hoe neuronen werken in het brein. Het brein ziet patronen die nauwelijks of niet in standaard-computerregels uit te drukken zijn, en neurale netwerken doen dat na met computerregels. Met als eerste grootschalig toegepaste voorbeeld dat van de herkenning van schrift, beginnende met het kunnen lezen van bankafschriften, waar aanvankelijk de eis aan gesteld moest worden dat ieder cijfer in een eigen vakje stond. Tegenwoordig gaat bijna iedere geschreven reeks cijfers zonder probleem, en inmiddels geldt dit ook steeds meer voor letters - iedereen kan het proberen op websites die "online ocr" aanbieden, 'ocr' staande voor "optical character recognition". Vrijwel alle vormen van drukwerk zijn geen enkel probleem meer. Maar essentieel aan het neurale netwerk was dat je het moest trainen: je gaf ze een groot aantal tests voor, en vertelde wat de goede en foute zijn - het netwerk, dat begint met niets-herkennen, stelt zichzelf dan in. En op dit punt zijn we in de huidige tijd, 2022, waar de laatste ontwikkelingen komen in de vorm van algoritmes die zelf verbanden uit de databestanden halen. Verbanden uitsluitend en alleen van de soort "Als getal A hoog, dan getal B hoog". Het algoritme heeft verder geen enkel benul waar A en B voor staan. Deze nieuwe neurale netwerken, algoritmes, hoef je niet te trainen in dat een dubbele nationaliteit een extra risico voor fraude is (niet-opgegeven huizen in het buitenland, geen wel-opgegeven kinderen al dan niet in het buitenland). Daar komen ze zelf achter. Ze leggen zelf verbanden tussen de namen van veroordeelden voor fraude uit de databestanden van de rechtbanken, en verbanden tussen namen en afkomst uit het buitenland. Maar dat is natuurlijk hartstikke fout van die algoritmes, want één de strengste gangbare alfa-theorieën is dat alle mensen en alle groepen mensen gelijk zijn, ongeacht geografische en etnische afkomst. Iedereen die dat tegenspreekt wordt achtervolgd en geterroriseerd met beschuldigingen van RACISME!!! en erger En dus moeten ook de algoritmes die dit tegenspreken verboden worden. En de weg naar verbod is via een campagne van verdacht en zwart maken. Hieronder volgt een verzameling bronnen uit die campagne. De meeste van die bron-artikelen gebruiken het volgende redenatie-schema: - De uitkomst is FOUT!!! - Dus, ergo, q.e.d.: de bron is FOUT!!! En indien ter sprake komt waarom de uitkomst FOUT!!! zou zijn: - De uitkomst is in strijd met "De Gelijkheid der Culturen". - Dus, ergo, q.e.d.: de bron is FOUT!!! In deze inleiding bespreken we er eentje omdat die daarop een uitzondering vormt, en desondanks het proces weergeeft (de Volkskrant, 24-06-2022, door Daan Ballegeer):

Die stelling uit de (hoofd)kop slaat op het tweede deel van het artikel, en kan je het beste uitleggen als "Als mensen hun vooroordelen weerlegd zien, nemen die vooroordelen vaak juist toe". Zie de Gelovige die met een ramp van de hand van zijn Almachtige geconfronteerd wordt. Het artikel start met de hoofdlijn:

Geen goede keuze van introductie, want natuurlijk wordt statistiek misbruikt voor eigen gewin want alles wordt misbruikt voor eigen gewin. Een veel betere introductie loopt via degene die statistiek op de kaart heeft gezet: Francis Galton Oftewel: dezelfde claim als nu gedaan voor algoritmes, met precies hetzelfde probleem Want de huidige visie op Galton's werk is "Galton = RACIST!!!" Verder met het bron-artikel:

Tja ... Waarom zou dat toch zijn ... Het antwoord: vraag je af wie dat "afschilderen" doen en welke belangen ze hebben. Het antwoord luidt: de alfa-intellectuelen (in de ruimste zin, dat wil zeggen: alles dat goed is in woordjes rijgen), omdat hun vrijheid van fantaseren en liegen wordt ondergraven.

Heel simpel: het zegt dat de elite, die dit soort zaken als onderwerp heeft, gedreven wordt door slechts één zaak: eigenbelang.

Klopt. Het is emotie tegen cijfers. Religie tegen beschaving. Alfa tegen bèta.

Dat zeiden we al ... Eigenbelang.

En een miljoen-miljard andere voorbeelden.

En daar is het eerste voorbeeld van het misbruik van statistiek: het bestaan van ongelijkheid (het resultaat van de statistiek) wordt zonder enige vorm van gebruik van cijfers verklaard tot een 'probleem'.

Wat bij deze dus al een keer verkeerd gegaan is.

Wat dus een gore leugen is van de alfa's.

Het onvermijdelijke vervolg van de eerste: je moet liegen dat je niet liegt.

Een argument dat niets zegt over de geldigheid van de gebruikte statistiek - beide uitspraken zijn waar maar spreken elkaar niet tegen.

Dat klopt. Maar dat is een overbekend deel van de statistiek: Hoe neem je een representatieve steekproef? Wat dus juist ondervangen is aan het worden door het gebruik van datasets: er wordt niets gevraagd dus er wordt geen steekproef genomen.

Een opmerking van de auteur van het krantenartikel. En een kenmerkend domme: ALLES heeft zijn beperkingen. Het gaat erom wat het minste beperkingen heeft. En het alternatief van meten heeft oneindig veel meer beperkingen. Het gebruik van deze domme en foute redenatie is een sterk teken van kwaadaardigheid.

En hier de reden: de alfa's willen sommige uitkomsten van statistiek en algoritmes bestempelen als 'discriminatie'. Zonder gebruik van cijfers.

Een reeks gore leugens: de Belastingdienst heeft jarenlang mensen betrapt die fraude pleegden, en daaronder bleek een aanzienlijke tot zware oververtegenwoordiging van allochtone immigranten Dat waren feiten, en die feiten zijn bestempeld als discriminatie. Oftewel: op grotere schaal in de echte maatschappij wat hierboven door de Volkskrant is vertoond. De Nederlandse regering heeft dat "erkend" omdat de Nederlandse regering volledig gedomineerd wordt door alfa's, met ideologisch oftewel emotioneel bepaalde meningen waarvan er één is dat ieder onderscheid dat negatief uitvalt voor gekleurde immigranten een kwestie is van discriminatie.

Iets dat volgde uit de datasets: mensen met dubbele nationaliteit pleegden vaker fraude dan die met een enkele (logisch: meer gelegenheid tot fraude, meer fraude).

Ook logisch: degenen die schenkingen doen aan instellingen verbonden met het buitenland, hebben meer banden met het buitenland, en mensen met meer banden met het buitenland, hebben minder banden met Nederland (alle stellingen van het tegendeel zijn gore leugens), en zijn meer geneigd tot fraude. Je hoeft dat er niet in te stoppen (vooraf bedenkt ook niemand dat), het is iets dat gewoon uit de datasets komt.

"Als de maan van groene kaas is ... ". Dat trainen is zonder enige twijfel niet gebeurd met deze vooronderstelling, maar dit zijn gewoon verbanden die uit de datasets zijn gekomen.

Juist! Het racisme of anderszinse emoties van mensen kunnen ze makkelijk ontkennen. Dat van het algoritme kan je aanwijzen. Er moet een regel zijn die dat doet. Nergens in de middels jarenlange discussies en debatten over "de toeslagenaffaire" is er ook maar enig bewijs opgedoken dat het in het algoritme zat. Terwijl er een grote druk was om met dat bewijs te komen. Dus dat bewijs en het racisme in de algoritmes is er niet. Wat de algoritmes hebben gedaan, is uitwijzen dat allochtonen vaker frauderen (wat logisch is, want allochtonen komen uit allochtone culturen en allochtone culturen zijn frauderende en corrupte culturen

Gehad.

Ja ... Wat dan, hè ...

Grote gruwel.

En daar gaat de econoom. De afgrond in. De afgrond genaamd "contradictie". Feiten:

Oftewel: de vertaling van wat de econoom zegt luidt:

En de dood van de beschaving is daar. Zodra de contradictie wordt toegestaan, heeft de redelijkheid geen enkele kans meer. "Waarom wordt het kindje geboren?" "God is Almachtig". "Waarom gaat het kindje dood?" "God is Almachtig". Etcetera. De econoom weet het eigenlijk wel:

Overigens weten we uitstekend, met slechts het kleinst mogelijke greintje gezond verstand, waarom vrouwen minder ongelukken hebben in het verkeer, en ook overal elders: ze nemen minder risico dan mannen. En niet een klein beetje minder ook ... Schijnt iets te maken te hebben met testosteron ... De rest van het artikel gaat over een vervolgonderwerp, naar hoe mensen beïnvloed worden door cijfers, enzovoort, met dus als hoofdthema wat samengevat is in de kop:

Neen! Veel te algemeen. Als je alfa's door middel van cijfers duidelijk maakt dat hun ideeën en ideologieën niet kloppen, dat wil zeggen: in strijd zijn met de werkelijkheid, gaan ze op emotionele en sterk emotionele wijze reageren. Logisch, want ze kunnen moeilijk op rationele wijze reageren, want dat zit in die getallen waar ze zo heftig bezwaar tegen maken. Jouw cijfers laten zien dat allochtone immigranten frauderen (logisch, want ze komen uit frauderende culturen), dan ben jij een RACIST!!! En XENOFOOB!!! enzovoort, tot aan iemand die doet aan gaskamers. Je wilt de niet-westerse immigratie stoppen: je bent een RACIST!!! en doet aan DEPORTATIES!!! Enzovoort. Als je van dit geval iets algemeens wilt maken, dan wordt het iets als dit:

En de praktijk laat zien dat deze twee, of drie, bijna altijd hand in hand gaan. De rest van de bronnen vertellen precies hetzelfde. Bronnen Het tweede artikel was al eerder genoteerd op deze plaats, vanwege eenzelfde soort rol. Ook dit is een boekbespreking (de Volkskrant, 19-01-2019, door Laurens Verhagen):

Dta zal verderop een gore leugen blijken. Dat 'nuchtere'.

Zo ingenieus zijn de algoritmes ook weer niet: het aanbod wordt ingedeeld in categorieën, wat de kijker kiest wordt vergeleken met die categorieën, en de volgende keer krijgt de kijker suggesties uit die categorie(ën).

En alweer krijgen we deze stupide opmerking. NIETS gaat ALTIJD goed. De vraag is "Waarbij gaat het meer goed?" En wat betreft kanker is dat allang uitgezocht en bekend: de algoritmes doen het aanzienlijk tot veel beter dan de dokter. De simpele verklaring: het algoritme wordt door geen praat van zowel patiënt als dokter afgeleid van waar het om gaat: de feiten. In dit geval: de meetbare symptomen. Al eerder geconstateerd; het maken van deze stupide opmerking kan zonder meer gekenmerkt worden als een vrijwel zeker teken van kwaadaardigheid. Hier de kwaadaardigheid van het willen laten domineren van alfa-emoties boven alles, zelfs overlevingskansen. Maar dit was eigenlijk nog slechts het minst schadelijke geval. Hier komen de ergere:

Idem in nog sterkere mate: zodra er ook maar enigszins een onzekerheid is in de feiten (de dader is niet betrapt staande over het lijk met het bebloede mes in de hand), gaat het zo ontzettend vaak gruwelijk mis dat je je afvraagt of het wel eens goed gaat. In Nederland heb je een beroemde reeks rechterlijke dwalingen Volgende vakgebied:

Het verkeer is nog een probleem voor het algoritme gezien het grote aantal vrijheidsgraden, maar in de luchtvaart is de grens al overschreden: automatische piloten maken minder fouten dan menselijke, en zijn mogelijk ook al beter in crisissituaties. Nou, nog meer voorbeelden nodig ... ? Het punt is: in het algoritme kan een in principe onbeperkte hoeveelheid ervaring, opgedaan door mensen, gestopt worden. Terwijl je die hoeveelheid ervaring niet zomaar in een mens kan stoppen - dat duurt vele, vele jaren. Goed: ook de boodschap van dit verhaal is dus al volkomen weerlegd. Maar men dramt hersenloos door:

Weer: op zijn minst is het zo het menselijke selecteren wordt gevoed met dezelfde data, dus dezelfde gekleurde data. Het algoritme biedt de mogelijkheid dat te ontdekken. Maar de goede mogelijkheid is dat dat selecteren hartstikke correct ging, en dat vrouwen gewoon minder presteren (bij de 100 meter hardlopen staat de eerste vrouw niet in de eerste 1000 mannen (duizend).

Wat alleen kan omdat die algoritmes werken. Hoe ze gebruikt worden zegt dus weer absoluut en helemaal evenveel als hoe een hamer of een mes werken. De oplossing is uiterst simpel: het gebruik van privé-gegevens verbieden, met straffen zoals een miljard boete. Bij wijze van spreken. Beloning voor wie het ontdekt en aangeeft.

Zo ongeveer, dus. En meteen een specifiek voorbeeld van de menselijke zwakte in het soort probleem waarvoor algoritmes geschikt zijn (de Volkskrant, 23-01-2019, door Casper Albers, hoogleraar statistiek aan de Rijksuniversiteit Groningen.):

Alhier wordt deze tweedeling aangeduid met "gezond verstand"

Hm, meestal staat het brein in de verkeerde modus. Eigenlijk is er maar één omgeving waarin het intellect het voornaamste gereedschap is: de natuurwetenschap (let op: dit sluit expliciet de menswetenschappen uit - die weten gewoon absoluut zeker dat alle culturen gelijk zijn, enzovoort, zonder op enige statistiek te letten - voor die mensen is statistiek niet moeilijk, maar onmogelijk).

Deze redactie kent een andere variant daarvan, in het kader van de effectiviteit van onderwijs (komende van de Engelse televisie, vermoedelijk Horizon): een groep PABO-studenten wordt de vraag voorgelegd waaruit een plant voornamelijk zijn groei haalt: aarde, water, zon (licht) of lucht. Relatief veel geven het foute antwoord "aarde", vanwege de intuïtieve gelijkstelling tussen de soort stof. Weinigen geven het goede antwoord: lucht. Dan geeft men de studenten les: de grote massa van de plant bestaat uit koolwaterstoffen en dergelijke, gebouwd op de koolstof afkomstig van de kooldioxide opgenomen uit de lucht. Vervolgens worden de studenten opnieuw getest, en ondanks de lessen geeft tot nog steeds een aanzienlijk aantal het foute antwoord.

Ook daarvan kent deze redactie een ander voorbeeld. Dit ging over de koop van een huis, met drie mogelijke keuzes. Na de eenmaal genomen beslissing wordt de koper uitgelegd dat zijn keuze niet de juiste (optimale) is, en een mogelijkheid geboden tot heroverweging. Relatief weinigen gaan daarop in (verklaring: het is moeilijk toe te geven een foute beslissing te hebben genomen). Dezelfde soort situatie werd "voorgelegd" aan mieren, die konden kiezen uit drie nestruimtes. Nadat net als bij de mensen de waardering van de keuzes werd veranderd. kozen ze, net als duiven natuurlijk, via "trial and error" uiteindelijk allemaal de optimale keuze. En hetzelfde geldt voor algoritmes: die worden niet gestoord door emoties en intuïties, maar volgen slechts de regels. Als de regels goed geprogrammeerd zijn, gebruik makend van hetzelfde soort regels als duiven en mieren hanteren, komen algoritmes beter tot het goede antwoord dan mensen. En dat kan al dan niet met gebruik van statistiek zijn. Een ongevaarlijk voorbeeld (de Volkskrant, 09-02-2019, door Laurens Verhagen):

Het staat er bijna expliciet: het is gewoon een patroonherkenner. Of dit intelligentie is ... Een illustratie van de onwetendheid omtrent algoritmes (de Volkskrant, 27-05-2019, door Jan Middendorp, VVD-Kamerlid):

Een hamer of een mes ...

Op grote schaal kunnen krant en televisie ...

Dat zijn geen algoritmes in de gebruikelijke betekenis.

Dat klopt. Voor die technologiebedrijven waar je je mee inlaat. Niemand hoeft naar Facebook enzovoort.

Dat is communisme.

Flagrante onzin. De meest kwetsbaren zijn degenen die dit het minst snappen - en dat is in dit geval bijna iedereen. Als er iets hieraan gedaan moet worden, kan dat op slechts één manier: verbieden door de overheid gevolgd door sancties op het niveau van sluiting van bedrijven. Of overheidsovername. Verder zal niets werken. Voorbeeld: cookies zijn het voornaamste middel van verzamelen van privacy-gegevens. Die kunnen instantaan verboden worden (of men kan het verzenden van gegevens van gebruikerscomputers verbieden). Men doet het niet omdat het belang van het bedrijfsleven oftewel de financiële markten altijd voor gaat.

De bestaande maatschappelijke structuren, oftewel de dictatuur van het neoliberalisme, heeft geleid tot de vrijwel gehele afschaffing van al deze controlemechanismes op bijna alle terreinen. Onder de noemer: zelfregulering. Maar in het begin stond ook nog een leuke:

Heel simpel: de gegevensstroom wijst natuurlijk razendsnel uit dat voor de technologische functies zoals van toepassing bij een ICT-begrijf als Amazon (bijna allemaal computerwerk) mannen gemiddeld beter scoren. Zeg: 70 procent kans op succes bij een mannelijke kandidaat tegenover 30 procent bij een vrouwelijke. Kennelijk bevatte de totale routine de stompzinnige aanpak om altijd de kandidaatsoort met de hoogste succeskans te kiezen (iedere statisticus weet dat dit onverantwoord is). Ergo: alleen mannen. Ook dat is niet een algoritme in de gebruikelijke betekenis maar gewoon platte logica. Het was gewoon slechte logica. Slechte logica gemaakt door mensen, zoals daarvoor bij het selectieproces ook eindeloos veel slechte logica wordt gebruikt door mensen, met behulp van de "algoritmes" in hun brein ("De kandidaat heeft geen stropdas dus hij kan niet programmeren"). En hier verwoordt een reageerder de echte existentiële angst van de algoritmofoben (de Volkskrant, 03-06-2019, ingezonden brief van Jan Venekamp, Beilen):

Brullen van de lach!!! De algoritmes halen slechts de patronen eruit, en het patroon is dat niet-westerse culturen vele malen corrupter zijn dan westerse

Brullen van de lach!!! De autochtone Nederlanders zijn gewoon eerlijk, en de gekleurden zijn oplichters:

Q.E.D. Van de bronnen hierna worden alleen de hoofdlijnen gegeven, want verder vertellen ze allmaal hetzelfde: algoritmes zijn niet te vertrouwen (de Volkskrant, 14-08-2019, door Corinne Cath-Speth, promovendus in Oxford, en Roel Dobbe, postdoc aan de New York University):

De kwaadaardigheidsindicator:

Dat 'rechtvaardig'. Bedoeld: niet allochtonen aanwijzen. De Volkskrant, 09-09-2019, door Tonie Mudde:

Die tussentitel vertaald:

Bingo. De Volkskrant, 02-10-2019, door Casper Albers, hoogleraar statistiek aan de Rijksuniversiteit Groningen:

Een leugen. Dat wordt uit de werkelijkheid gehaald.

Namelijk: de misstand dat de gang van zaken in de maatschappij bepaald wordt door emoties van alfa's, die op iedere resultaat dat ongelijkheid laat zien, scheldwoorden plakt als "DISCRIMINATIE!!!"en "RACISME!!!" Net als deze auteur als columnist systematisch doet in de Volkskrant met smerige politiek-correcte praatjes. Een samenvatting (de Volkskrant, 31-10-2020, ingezonden brief van Thijs van der Heijden Bussum):

Dram, dram, dram. En dat gedram komt in de Volkskrant in hoge mate van dit figuur, dat 'ict" als specialisme heeft, en hier komt met zijn bijdrage aan het jaaroverzicht (de Volkskrant, 24-12-2020, door Laurens Verhagen):

Het is een uitermate naargeestig politiek-correct dramfiguur die volkomen past bij de ratio-hatende Dramvolkskrant. De Volkskrant, 24-11-2021, redactie:

Daar staat het eens goed: het algoritme werd niet verkeerd getraind, maar haalde haar correlaties uit de werkelijkheid. In de werkelijkheid is het aanvragen van kinderopvangtoeslag een risico omdat er volstrekt onvoldoende op gecontroleerd werd of kon worden. Kinderopvang is private sector en deels kleine ondernemers voor wie het makkelijk frauderen was. En uit gewone berichtgeving kon je al opmaken dat een groot deel van de fraude kwam van allochtonen. En in 2021 ...

... was dat om die reden al succesvol zwart gemaakt. Het algoritme, dat is. Niet de frauderende allochtonen. Een klassiekertje (de Volkskrant, 22-01-2022, door Kim Bakker):

Brullen van de lach!!! Volledige naam: Safiya Umoja Noble. De natuurlijke vijand van alle techniek is natuurlijk deze soort mens (de Volkskrant, 26-02-2022, boekrecensie, door Marjan Slob):

Recensent Slob Door de geest van de Franse filosoof waart een algoritme dat dicteert dat hij politiek-correcte prietpraat uitslaat en hijzelf daardoor weinig tot niets meer te vertellen heeft. Geinig. Iemand die het verschijnsel opmerkt (de Volkskrant, 05-07-2022, column door Fleur Jongepier, filosoof en essayist voor Bij Nader Inzien):

Tjonge ... Vroeger belden ze elkaar, en nu sturen ze elkaar berichtjes via het internet ... Maar ja, het zijn alfa's, hè ... En dan krijg je dit soort redenaties: - Wij haten boeren want werkende blanke Nederlanders dus willen we ze onteigenen om op hun land immigranten uit de woestijnen te huisvesten. - Wij haten het internet want een plek waar gewone werkende blanke Nederlanders dus ook boeren elkaar kunnen treffen zonder dat wij dat onmogelijk kunnen maken. - Dus, ergo, q.e.d.: het internet is verantwoordelijk voor de boosheid van de boeren die wij willen onteigenen. Een redenatie zo stupide dat het zelfs in eigen kringen opvalt:

Ach jee ...

Ach jee ... Overigens, dit ...

... is het resultaat van het algoritme dat heet "mainstream media", of "reguliere media", of gewoon "de media", welke algoritme zegt: "Wat uit de Joodse of Arabische asociale woestijn komt is GOED!!! en wat van de Europese sociale weide komt is FOUT!!!". Eigenlijk geen algoritme maar gewoon één van de logische regel horende bij het Ideologisch Absolutisme. Dit omdat de andere kant van het verschijnsel 'boeren die hele snelwegen lam leggen', zijnde "elite die hele boeren lam leggen", niet genoemd wordt. Oftewel: dat volgens de filosoof "elite die hele boeren lam leggen" niet bestaat. En aangezien in de werkelijkheid "elite die hele boeren lam leggen" wel bestaat, ontkent de filosoof hier dus het bestaan van de werkelijkheid. Een typisch gevolg van Ideologisch Absolutisme, namelijk Ideologische Blindheid. Welke verschijnsel bij de filosoof hoogstvermoedelijk verklaard wordt door het feit dat in de media het voortdurend gaat over 'boeren die hele snelwegen lam leggen', terwijl "elite die hele boeren lam leggen" niet genoemd wordt of op een dusdanige manier dat het logisch is dat "elite ... hele boeren lam leggen". Oftewel: "de media" doen ook aan algoritmes, dit algoritme dus zijnde: "Elite die hele boeren lam leggen" is GOED!!! en 'boeren die hele snelwegen lam leggen' is FOUT!!!". Welke Ideologische Blindheid ook hier, net zoals gewoonlijk, gepaard gaat met Ideologische Emotionaliteit, hier vervat in dat ene bijvoeglijke naamwoordje 'hele'. Boeren leggen niet snelwegen plat, maar leggen hele snelwegen plat. Dit alles ter illustratie van het feit dat verwijten vanuit de richting van "de media" richting zij die algoritmes gebruiken, net zo correct zijn als verwijten van potten aan ketels dat ze zwart zien. Waarna de filosoof wat voorbeelden van die onterechte verwijten noemt, door de oorzaken van de door de media aan de algoritme toegeschreven verschijnselen te noemen:

Waar gewoon de meerderheid er Britten voor was, terwijl de algoritmes van de media er sterk tegen waren.

Waar gewoon de meerderheid der Amerikanen voor was, terwijl de algoritmes van de media er tegen waren. Ziet dus ook de filosoof:

En dat dan nog zonder het noemen van de andere kant van het verschijnsel algoritme:

Want de wetmatigheden die de keuzes van de media bepalen, de al genoemde Wetten van de Joodse en Arabische Woestijnen, zijn net zozeer algoritmes als die van de computers, zij het dat die Woestijnwetten van de media op neuronen draaien, in plaats van siliciumchips. En dat die media-algoritmes uit Joodse en Arabische Woestijnen komen, is iets dat zelfs de filosoof per ongeluk illustreert:

Die Yuval Noah Harari is een Joods en Arabisch Woestijndier van de eerste soort, boordevol Joodse en Arabische Woestijn-algoritmes die proberen de geesten van de Europese boeren en overige weide-bewoners te hacken zoals dat eerder gebeurd is met het christendom en heel recent de islam. Misschien is het toch verstandiger van de politiek-correcten dat ze zich voor de volle honderd procent aan de Ideologische Blindheid houden, want zodra ze ook maar een substantieel percentage van de werkelijkheid toelaten, zoals hier, stort meteen het hele griezelkasteel in elkaar. En een paar dagen later legt de Volkskrant nog eens uit wat er nu echt mis is met algoritmes (De Volkskrant, 06-07-2022, rubriek Huh?! Opmerkelijke onderzoeken, door George van Hal):

Ja hoor! Zo:

Gunst, daar heb je echt geen algoritme voor nodig, om to zwartenbevoordeelbeleid te komen. Dat doen de neurologische algoritmes volkomen automatisch. Maar dat zijn dus de goede algoritmes. En foute zijn ...

Verrek ... Het lijkt de werkelijkheid wel ... ... Een paar uur later bedacht het neurologische algoritme de (vermoedelijke) werkwijze van de silicium-versie. Eerst had het de gegevens van, zeg, vijf jaar gearresteerden wegens schietpartijen gekregen, opgesplitst naar etniciteit want dat mag in Amerika (voor de Nederlandse versie, zie hier Vervolgens had het uitgerekend dat 99 procent daarvan zwart was (in zuid-westelijke staten krijg je daar een flinke portie latino's bij, maar dit is Chicago, in het noorden). Vervolgens had het algoritme alle andere gemeenschappelijk eigenschappen bij elkaar genomen en gerangschikt naar sterkte. Met bovenaan als eigenschap: gezin met of zonder vader, en uitkomst: 80+ procent zonder vader. Daarna was hun woonplaats binnen Chicago opgedeeld in de verschillende buurten en wijken, welke het neurologisch netwerk niet kent maar naar analogie zich kan voorstellen dat dit net zoiets oplevert als het verschil tussen Kralingen en IJsselmonde (of Buitenveldert en Bijlmer, e.d.) En tot slot had het algoritme deze verdelingen losgelaten op alle jonge zwarte mannen, met de uitkomst van 56 procent. Hartstikke logisch, allemaal. Had geen algoritme aan te pas hoeven komen, maar toch prettig om gezond verstand-oordelen bevestigd te zien. Eén van de uiterst belangrijke zaken waar je software voor kan gebruiken is dit (de Volkskrant, 15-07-2022):

Zonder die software is op die manier corona-veilig tentamen-afnemen in het geheel niet mogelijk, en de manieren om met bovenstaande methode fraude te plegen, zijn ook nog steeds legio (deze redactie gaat ze niet opnoemen om geen slapende fraude-gevoelige hondensoorten Maar ja, je moet wat in corona-tijden. Maar, blijkt, de software werkt niet helemaal goed ...

Niks bijzonders, natuurlijk. Software in vliegtuigen en raketten werkt ook soms niet goed en die wordt oneindig veel beter gecontroleerd en getest dan dit soort massa-product. Maar ja, "slachtoffer" ...

... heeft kleurtje, is "mens van kleur", dus is er meteen sprake van ... (de Volkskrant, 15-07-2022):

... , want mensen van kleur zijn hartstikke gelijkwaardig en ieder verschil is het gevolg van discriminatie en racisme. Daarvoor zijn speciaal door de elite diverse instellingen en organisaties opgericht zoals dat genoemde College voor "Ieder Nadeel voor of Minder Punt van Gekleurde Mensen is Discriminatie en Racisme", het "CNMPGMDR", een instituut met een lange staat van dienst Dit naast diverse onder de burgers van GOEDE!!! komaf spontaan ontstane initiatieven ter bestrijding van discriminatie en racisme, zoals het "MNMPGMDR": het "Media voor Ieder Nadeel voor of Minder Punt van Gekleurde Mensen is Discriminatie en Racisme", en hier met name het "VNMPGMDR": het "Volkskrant voor Ieder Nadeel voor of Minder Punt van Gekleurde Mensen is Discrminatie en Racisme". Welk laatste het op een detailpunt wat minder functioneren van deze software weet te vertalen tot ... :

... terwijl die software evenveel weet wat een 'mens' is als de eerste de beste lantarenpaal, of mooier: voordeurlicht dat aangaat als u voorbijloopt. "Kijk eens wat mooi ... Hij herkent me!" Kirt de door geen enkele vorm van rationaliteit gehinderde alfaziel En om totaal van iedere emotie gespeende technologische attributen als software te voorzien van de o zo noodzakelijke hoog-emotionele dimensie, in verband met "MNMPGMDR" en "VNMPGMDR", is het dus nodig om ...

... twee hoog-emotionele ...

... en van iedere rationaliteit gespeende alfa-figuren aan de taak van het vertalen te zetten. Er staan geen fotootjes bij het artikel want dat is niet gebruikelijk bij Eerste Katern-vullers, maar we weten zeker dat ze niet te onderscheiden zullen zijn van de collegaatjes van het Magazine die daar scheutiger mee zijn en allemaal voldoen aan het "Aaf Brandt-Costius Begonias Het soort figuren dat ook nooit de ongewenste realiteit zal waarnemen, zelfs als die realiteit ...

... zo dicht voor de neus staat dat ze het hele gezichtsveld in beslag neemt. Natuurlijk is het moeilijker herkennen van "zwarte" gezichten een ordinair technisch probleem dat te maken heeft met licht-donker contrasten en -contouren, en met enige moeite opgelost kan worden. Maar ja, het is hetzelfde als met schoenmaatje 58: daarvoor draait de fabriek echt niet. Die zal je met de hand moeten laten maken. Want van schoenmaatje 58 zijn er zo weinig, dat het bouwen van een fabriek ervoor te duur is. En met zwarte studenten ... Enfin, u snapt het, dit wordt te discriminerend en racistisch, en bovendien is het best mogelijk om die software te verbeteren, maar daarvoor moeten ze er gewoon wat tijd en mensenwerk oftewel geld erin steken en je weet hoe dat gaat bij bedrijven. Geheel los van enige overweging van huids- of andere kleur. En hoe vaak treedt dit soort probleem nu in het algemeen op? Nou, zo vaak, dat om de geschiedenis van dit soort software-probleempjes te illustreren, de theekrans-dames terug moeten grijpen ...

.. naar een geval uit 2015, zeven, ZEVEN, jaar geleden, en een geval dat helemaal niets te maken had/heeft met gezichtsherkenning, maar probeerde het onderwerp van foto's te herkennen, en dus absoluut niet let op details als onderscheid in "gezicht". Maar ja, wat je wel raden wat de theekrans-dames gedaan hebben ... Hetzelfde als de mens van kleur:

... en dan krijg je natuurlijk inderdaad resultaten, want het internet is tegenwoordig zo groot dat je ook resultaten krijgt op "ijsbeer + meloen". En de theekransdames vonden natuurlijk vooral dat "gorilla"-aspect iets om te zoenen. Na afloop gezellig nakletsen onder genot van wat roomsoezen ... Hops, weer wat DEUG!!!-dopamine gesnoven ... ... Voor de volledigheid: hier is het geval van gorilla-racisme van Google uit 2015, destijds met een brullende lach door deze redactie genoteerd (CNN.com, 02-07-2015,

De firma Google heeft naast zijn zoekmachine ook diverse andere diensten, waaronder één voor de opslag en het delen van foto's. De opgeslagen foto's worden, ten dienste van het zoeken ernaar, automatisch voorzien van korte begeleidende en beschrijvende tekst. Daartoe heeft Google een herkenningssprogramma ontwikkeld dat aan de hand van het beeld, hoofdzakelijk de contouren mag men aannemen, bepaalt wat voor soort voorwerpen op de foto staan. Hier is het "beledigende" resultaat:

De foto met het vriendinnetje krijgt de omschrijving toebedeeld van "gorilla". En constateert de vriend verontwaardigd ... :

"Het is alleen bij de foto's met haar erbij dat het gebeurt" ... Ja, omdat alleen haar contouren lijken op die van een gorilla. Kan de gorilla niets aan doen. Nog minder de software. De natuur is hard Dus ... :

... bevat twee leugens - nummer 1 het ging niet om 'zwarte mensen', want het gebeurde niet bij de zwarte vriend van het slachtoffer. Nummer 2: het ging niet om 'mensen', maar slechts één persoon. De betrouwbaarheid van de rest van de beweringen ligt dus onder de 50 procent Een niet gevoelig onderwerp, en meteen krijgen we een prima uitleg van hoe het werkt (de Volkskrant, 21-07-2022, rubriek Huh?! Opmerkelijke onderzoeken, door George van Hal):

En op dezelfde soort manier leert een algoritme onderscheid maken bij fraudeurs, tot het uiteindelijk uitkomt bij, onder andere, mensen met twee paspoorten. En dergelijke. De mensen die in straten wonen waar in iedere woning een invalide met een parkeervergunning huist ... Vermoedelijk een voorbeeld van Volkskrant-ironie ... (Volkskrant.nl, 11-09-2022,

Klopt: allochtonen betrappen op fraude

Klopt, als je "de media" volgt.

Wat we al zeiden: een machtig wapen in handen van de overheid op het betrappen van fraude dus meestal allochtone fraude, wat "de media" dan 'discriminatie' of 'onterechte straffen' noemt. Die privacyschending door techbedrijven willen ze niks aan doen, want als ze het willen is het met één klap op te lossen: hef de bedrijven op die het doen (begin bijvoorbeeld met het verbieden van het gebruik van cookies ervoor - heel simpel na te gaan want die cookies worden met de miljarden verspreid - wie betrapt wordt: boete van halve jaaromzet).

Klopt.

Doe je best.

Dus vooral niet, want dat 'we' is op zijn best het alfa-tuig En als je mensen als K. Bessems En daar zijn ze met z'n tweeën in vol ornaat. K. Bessems en S. Ghebreab met de tactiek waarin K. Bessems zich aan het specialiseren is, de uitgebreide versie van A. Grunberg's "Ik ben je vriend, maar ..." (de Volkskrant, 01-10-2022, door Kustaw Bessems):

Het "Ik ben je vriend ...". En hier:

... het eerste "... , maar ...". En hier nog wat "maars":

Een leugen. Het gebeurt alleen via een computer, al dan niet op het internet. Trek de stekker eruit:weg AI.

Een leugen: AI is neutraal, want het AI begrijpt niets, maar het gebruik van haar resultaten hoeft niet neutraal te zijn.

Leugens van K. Bessems: die tweede nationaliteit is een objectieve maat voor meer fraude, en fraude met sociale uitkeringen vindt je in wijken met sociale uitkeringen. Let op: alle twee niet een zaak van AI.

Door de leugens en machinaties van K. Bessems cum suis.

"Als de maan van groene kaas is ... " Discriminatie en uitsluiting zijn geen probleem, laat staan een groot. Van allochtonen, dat is.

Herhaling, herhaling, herhaling. Voortdurend wordt dit herhaald. De Joodse en islamitische mantra's uit de woestijn. Oeoeooeoeoeoemmmmmm!

Eindeloos veel.

Bijna alle of misschien wel alle problemen die van belang zijn. Voorbeeld:

Er is maar één plaats waar AI als echoput kan werken: op het inernet. Daar hebben alleen mensen die het opzoeken mee te maken. Er is ook een echoput vol nepnieuws buiten het internet. Dat zijn de reguliere media. Daar is het maatschappelijk functioneren van afhankelijk, maar dat probleem kan absoluut niet met AI opgelost worden. Daarvoor heb je touwen en valbijlen nodig. En tribunalen. Oh ja: onderschrift bij de foto:

Waar staat: "Ik ben een oplichter die blanken haat". Want: AI kent alleen getallen en weet niets, en dus ook niet wat "mensenrechten" is, en kan dat dus respecteren noch bevorderen. Wat daar dus staat is dat S. Ghebreab AI wil hanteren om gekleurden te bevoordelen, want dat is wat de term "mensenrechten" in de praktijk doet: gekleurden vrijpleiten van fraude of soortgelijke zaken omdat ze gekleurd en minderheid zijn, want het corrigeren van frauderende minderheden of gekleurden is "een schending van de mensenrechten". Zie bijvoorbeeld wat het College van de Mensenrechten doet Op naar de volgende die over de toeslagenaffaire begint. Hops, en daar is de zoveelste hoeveelheid waanzin over het internet en de algoritmes weer, met haar huidig favoriete geval: TikTok (de Volkskrant, 28-01-2023):

En wat is het huidige alfa-intellectuele

Een uitstekende achtergrond om niet te weten dat TikTok en haar algoritmes alleen in naakte getallen handelen, en totaal nul komma nul besef hebben van wat die getallen betekenen. Je deelt je aanbod in in hokjes (dat kunnen ook de mensen doen maar dat doet er niet toe: hokje = naam = getal), en je telt de hokjes van je gast, en hoppa: klik op 12 hokjes 12345, en je krijgt meer van hokjes 12345:

En dat geldt voor alles waar je veel op klikt. Dus ook op ... :

... met met een zwakke geestelijke gesteldheid in dit geval van de vrouwelijke kunne in welk geval de zwakke geestelijke gesteldheid meestal te maken heeft met het uiterlijk (zo niet voor 100 procent altijd), waarna er in veel gevallen eetproblemen volgen van diverse soort. Waar deze schrijvende en media-strategende mevrouw met de zwakke geestesgesteldheid en de al dan niet actuele eetstoornissen dan tranentrekkende verhalen over gaat houden:

... , wat het voor iedereen sluitende bewijs is dat TikTok niet deugt. En dat dan wee twee pagina's Volkskrant lang. Oftewel: van de 100 geboren kinderen zijn er drie gehandicapt (of noem maar een getal). Dus die Geboren-worden firma is een schurk. Tegen het risico's van de Geboren-worden moeten de kwetsbare Geboren-wordenden beschermd worden. Door de firma van het Geboren-worden te verbieden, natuurlijk. ... En voor dit verhaal werd dat plaatje opgeslagen in het archief, waar dus ook dit bleek te staan (de Volkskrant, 12-11-2022:

Nog een aflevering van dezelfde rotzooi tussen de laatste twee genoteerde in. Verzin zelf maar een naam voor het algoritme dat tot dit soort stompzinnig repetatief gedrag leidt. De bèta-hatende journalisten zoeken het "hogerop":

Ja ja, lacht u maar ... Accountants ... Naast stofzzuigerverkopers-aan-de-deur het meest gerepesteerde berope in Nederland ... Maar goed, je moet altijd ieder individueel geval idividueel behandelen. Eerst even de specifieke kwestie:

De oplossing van de stofzuigerverkopers:

... : stofzuigerverkopers. Goh, wat een verrassing ... Nou is de door de heren voorgestelde oplossing natuurlijk ook niks, alleen al door de beperking tot een half jaar. En ten tweede is zoiets nog moeilijker af te dwingen dan een pauze op alcohol of seks. Dat ontwikkelen van AI wordt namelijk, voor zover het gevaarlijk is, helemaal niet gedreven door lust tot ontwikkelen laat staan het welzijn van de mensheid, maar door machtswellust in diverse vormen, en geldlust. Kijk maar naar de rijken in de ICT: Zuckerberg, Page & Brin, Ellison, the new kid on the block Altmann, de man van dat ChatGPT: allemaal leden van de stam van De Dansers rond het Gouden Kalf, die door Jezus uit de Tempel gejaagd werden En de stofzuigerverkopers gaan absoluut helpen in het bestrijden van de Kalfdansers, want die vreten uit hun ruif. En dat is natuurijk wat de stofzuigerverkopers verder nog allemaal voorstellen:

Terwijl de echte oplossing uiterst simpel is en aan beide eisen uit de koppen voldoet: verplicht het openbaar maken van alle software. Nummer 1: iedereen kan altijd (laten) controleren wat die software doet, en nummer 2 en de belangrijkste: het verliest volkomen de interesse van de Zuckerbergs en de rest van het Kalfdansers en soortgelijken, want je kan er niet meer steenrijk mee worden. En dat is dus de oplossing die u van de stofzuigerverkopers nooit zult horen. En oh ja, wat is nu eigenlijk het gevaar van die AI:

Volkomen onzin: veruit het meeste nepnieuws wordt verspreid door de reguliere media

Oftewel: het ernstige risico van het naar buiten komen van de corruptie en achterlijkheid van allochtone culturen Een zeer verhelderend stuk met van alles bij elkaar::

De auteur is een blanke cultuur hatende moslim.

Geldt overal ter wereld en met name in Amerika als zwart, en die gemengde gevallen ...

... zijn vaak het ergste. Overigens geldt het geval ook medisch gezien als zwart, want daar gaat het om medische risicofactoren die zwarten extra hebben, en de arts die daar geen rekening mee houdt, benadeelt zwarten en is dus een racist (zie het soortgelijke geval van vrouwen). Door de witte genen ...

... kan ze dus wat, en door haar zwarte genen ... :

... gebruikt ze de voodoo van het specifieke voorbeeld om het gemiddelde te weerleggen: "Omdat Yashahiro Kobayashi langer is dan Wim Jansen, is de regel dat Nederlanders langer zijn dan Japanners niet geldig". Nou zijn er ook eindeloos veel niet-zwarten die dit soort voodoo hanteren, maar gedompeld in zoveel racisme wordt je vanzelf ook racistisch. En het staat er ook allemaal letterlijk:

Tja ... Dus als algoritmes tot de conclusie komen dat Nederlanders langer zijn dan Japanners, en dat ...

... dus niet altijd even positief uitpakt voor de Japanse minderheid, en dus ook voor ...

... mensen uit corrupte culturen ('jonge moeders' = "zwarte tienermoeders"), is dus allemaal de schuld van ...

... , zoals ...

... het discrimineren van zwarten bij de eindeloos veel gratis opleidingen op het internet om iets van computertechnologie op te steken. Het weergeven van een media-hysterie is lastig want een groot deel ervan zit in de de hoeveelheid. De eindeloze herhaling van steeds dezelfde rotzooi. Multiculturalisme, immigratie, stikstof, kernenergiebedreiging, extreemrechts, ... De werking van al die campagnes zit in de onbeperkte herhaling, van de alfa-visie op die dingen, zonder één enkel oog voor de feiten. Media = alfa-terreur. Met nu dus de "ALGORITMES!!!" Of "AI!!!" of "articial intelligence" en noem maar op. En het is weer zo intens in "de media' dat het zelfs die plekken heeft bereikt waar men vaak nog een tikje nuchterder is dan "TOTAAL HYSTERISCH". En het begint al meteen goed:

HOPELOOS!!! Een student geschiedenis over algoritmes ... Een student algoritmes die iets zou insturen over geschiedenis niveau "Amerika is de meest vreedzame natie op Aarde" zou driehonderd keer worden uitgelachen. Om te beginnen al vanwege het taalgebruik want een student algoritmes kan natuurlijk gewoon niet lekker vlot schrijven, want anders was het wel een student geschiedenis geworden. En studenten geschiedenis kunnen niet goed redeneren, want als ze goed konden redeneren, waren ze wel student algoritmes geworden want daarmee kun je veel beter je brood verdienen. Maar lekker vlot schrijven kunnen ze dus wel:

En die kop komt niet van de Elsevier-redactie, anders dan dat ...

... 'nucleaire wapens' is afgekort tot 'kernkoppen'. Eén enkel voorbeeld van "redenatie" voordat we het hele epistel reproduceren:

Uit de geschiedenis van DE TECHNIEK: "Mensen zal de adem benomen worden en sterven vanwege de enorme snelheid ...

... van de stoomlocomotief". En: "Het paardloze rijtuig is een dodelijk gevaar dat streng gereguleerd moet worden, met bijvoorbeeld voor ieder exemplaar een man met een rode vlag ...

... . want gisteren is er al iemand omgekomen die werd overreden door het nieuwe levensgevaarlijke monster". Maar ja, geschiedenis van DE TECHNIEK is natuurlijk iets waar studenten geschiedenis echt helemaal niets van weten, want als ze ook maar de geringste affiniteit met techniek hadden, waren ze wel iets in de techniek gaan doen, want ..., Enzovoort. Hier is dus het hele product van de student geschiedenis:

Met nog eentje geleend van GeenStijl die als aanleiding had berichtgeving over Russische berichtgeving die moslims in een negatief daglicht zou proberen te stellen, hier in de vorm ... :

... , in beide gevallen de riposte zijnde: "Dat kunnen ze zelf veel beter!" (sociale terreur, aanslagen, "Zwarte Piet!!!", "Slavernij!!!") En het nevenstaande ... :

... met ietwat explicieter: "Dat kunnen mensen veel beter!". Overigens: was Gavrilo Princip niet zoiets als "student geschiedenis"? En kunnen we dan niet beter massamedia verbieden? Want dus ook Elsevier blijkt dus in het geheel niet immuun:

En:

En die rotzooi hebben we niet eens meer bekeken ... Na deze analyse bijna overbodig, toch nog maar de beloofde andere aanleiding voor voorgaand commentaar, van een dag eerder uit de Volkskrant, met onveranderd commentaar want we hebben geen zin meer in de moeite: Columnist: overal verstand van en overal opinie over. Gebrek aan verstand geen bezwaar - je schrijft gewoon op dat 't zowel kan vriezen, ... (de Volkskrant, 22-04-2023, column door Emma Curvers):

... of kan dooien. Redenen dat 't kan vriezen:

En die dat 't kan dooien:

Hm, dat is toch heel wat meer vriezen dan dooien. Maar deze selectie is natuurlijk het resultaat van ... :

... het nieuws dat Enterprising Emma ontdekt heeft, en het

... verder kijken dan de eigen krantenwijk. Overigens lijkt het in eerste instantie inderdaad uiterst opmerkelijk dat een stuk techniek kennelijk zo makkelijk zich kan voordoen als een menselijke auteur. En dat, weet iedere ingevoerde, uitsluitend gebaseerd op het op één hoop gooien van wat menselijke auteurs van het type E. Curvers allemaal in de openbaarheid pleuren. Oftewel: wat die verzanel-en middelaar-algoritmes laten zien is dat datgene wat de media vult, één grote vuilnisbelt van lege rotzooi is. Eindeloos veel woorden, en nul inhoud met slechts een zeer geringe mate van afronding. Met dit stukje als voorbeeld. En ergens weten ze het nog ook:

Precies! Rotzooi! Columnisten zijn gewoon menselijke varianten van ChatGPT als producenten van rotzooi. En voor de rest van de journalistiek geldt natuurlijk precies hetzelfde. De Volkskrant grossiert tegenwoordig in de meest sneue en domme figuren als columnist. Dat heeft soms zo zijn voordelen. Met het volgende product wordt de sneuheid van het geschrijf over TikTok in één klap volkomen helder (de Volkskrant, 29-04-2023, door Merel van Vroonhoven (pag. 2)):

Ja ja, door de nulletjes en ééntjes die de computer van TikTok krijgt raakt die computer volkomen verslaafd aan de nulletjes en ééntjes van TikTok ... Een voorbeeld:

... dat computers ...

Waarna er jarenlange therapie door computertherapeuten nodig is om de computer weer te helen. Net als bij alle andere aspecten van de alfa-intellectuele en politiek-correcte waanzin kent ook deze geen grenzen. Een hele week lang was er een serie over minimaal twee pagina's in het midden van de krant over de nakende ondergang ten gevolge van de algoritmes, beginnende op maandag zo (de Volkskrant, 08-05-2023):

Allemaal met deze uitstraling en boodschap (Volkskrant.nl, 08-05-2023):

"HET MONSTER VAN FRANKENSTEIN IS GEKOMEN!!!" Het monster van Frankenstein dat het gevolg was van de uitvinding en toepassing van elektriciteit, weet u wel ... Onmiddellijk afschaffen, die elektriciteit! Mensen gaan eraan dood, en je kan er misschien in de toekomst zelfs executies mee uitvoeren ... En dat een hele week lang. Zoals bijna altijd was er slechts één plek waar je wat rede kon vinden (de Volkskrant, 15-05-2023, ingezonden brief van Govert Geldof, Tzum):

Maar dat is natuurlijk slechts een druppel op een gloeiende plaat (de Volkskrant, 15-05-2023, column door Sander Donkers):

En (de Volkskrant, 17-05-2023, ingezonden brief van Kees Eilander, Nijmegen):

Weer een nieuwe nog ernstigere BEDREIGING!!! GEDACHTENLEZEN!!! Wat inderdaad in die richting lijkt te gaan: met behulp van MRI-scanners kan je zien wat voor beelden er in de geest rondgaan. Nu nog ruwweg maar dat gaat natuurlijk verbeteren. HARTSTIKKE ENG!!! En GEVAARLIJK!!! Even vergeten te vermelden dat je dat doet met een apparaat dat een ton weegt en waar je stil in moet gaan liggen. Ook dat zal in de toekomst mogelijk wat lichter en makkelijker worden, maar je zal altijd zelf een apparaat op je kop moeten zetten. En de gevolgen zijn ook nog allemaal beschreven ook. Archetypisch voorbeeld:

Anno 1984. Met eindeloos veel navolgers. Maar ach, we zijn alfa-intellectueel/politiek-correct/zombie, dus we hebben een mening. Kwamen we daar laatst niet een mooie definitie van tegen ... Oh ja, bij dat product van Donkers:

Amen. De hetze heeft nu ook de goedkopere rangen bereikt. En dat is meteen te zien (de Volkskrant, 27-06-2023, door Bart Wernaart, lector Moral Design Strategy aan de Fontys Hogeschool Economie en Communicatie., en Daniëlle Arets, lector Journalistiek en Verantwoorde Innovatie aan de Fontys Hogeschool voor Journalistiek):

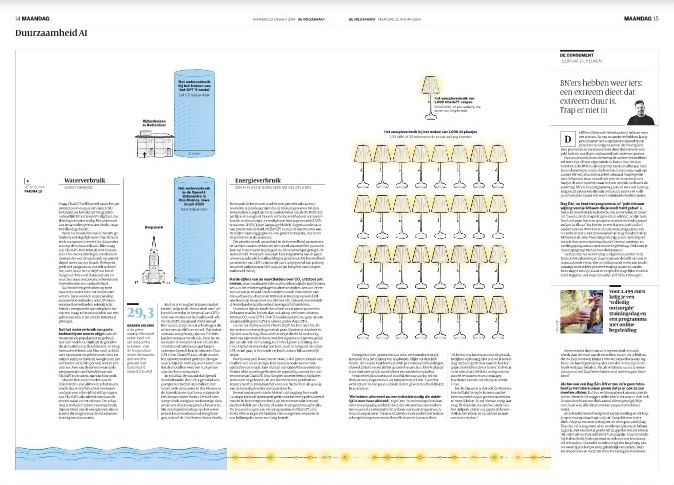

De nadelige milieugevolgen van AI ... Poept of piest die AI misschien? Of stoot ze zwavelachtige dampen uit ... ? Maar dat wordt meteen overtroffen door dit:

"Slager, gaarne vier biefstukjes van circa twee ons." "Zeker mevrouw. Dat is dan 10 euro en 2 euro vijftig btw". Oftewel: belasting ... Gaan we die AI dan afwegen op een weegschaal? En een paar zinnen onderweg:

Yuval Noah Harari is een Joodse fantast en waarzegger, en iets dat verder van de tech afstaat dan dat is nauwelijks denkbaar.

Oh ja, we kwamen laatst het allereerst alhier genoteerde geval weer tegen. Eens kijken of we het weer kunnen vinden. ... En ja hoor! Maar eerst even dit afhandelen:

Inderdaad: even zinnig als de voorstellen voor herstelbetalingen voor de slavernij: "Uw afkomst is voor 59,8 procent slaaf, en voor 21,3 procent slavenhouder. Dat is dan 3 euro vijftig inclusief". Overigens zijn er al stromen voorbeelden van domme resultaten van ChatGPT langsgekomen. Mogen de makers van ChatGPT dan ook schadevergoeding vragen aan diezelfde geregistreerde auteurs? En als laatste klaroenstoot:

Een creatieve computer ... Is het mogelijk dat dit artikel ook door ChatGPT is geschreven, in plaats van mensen? Oh ja, dat oude artikel nog (Joop.nl, 28-05-2017,

Een keiharde leugen. Wiskundige reeksen zijn net zo niet-neutraal als stenen. Vermoedelijk is er door de negerin andere terminologie gebruikt om de uitkomst te bestrijden. Die uitkomst is niet neutraal, want de werkelijkheid is niet neutraal - gezien vanuit politiek-correcte en gekleurde ogen.

Een leugen. Patroonherkenning wordt niet vooraf ingeprogrammeerd, maar gaat via neurale netwerken en die wordt de herkenning aangeleerd. En kijk-er-de-kijk: een reageerder bij Joop.nl, geen wetenschapper maar iemand met gezond verstand en een greintje praktijkervaring, heeft het probleem door:

Brullen van de lach!!! Een student heeft het begrepen. Wil je goed kunnen parasiteren, moet je goed in de markt liggen. En wil je goed in de markt liggen, moet je aandacht voor jezelf zien te genereren. En wil je aandacht voor jezelf genereren, moet je in de media zien te komen, En om in de media te komen, moet je politiek-correcte stukjes schrijven. Dus schreef de student een politiek-correct stukje (de Volkskrant, 03-07-2023, door Lucas Kroes, masterstudent Computer Science - Artificial Intelligence aan de TU Delft):

Dus komt de student in de krant (de Volkskrant, 03-07-2023):

Dit dus allemaal volgens de zombie-logica. In dit geval een voordeel, want door het uitsluitend in het bezit zijn van zombie-logica, ontging het de politiek-correcte zombies dat de student, door de juiste terminologie te gebruiken, het omgekeerde bereikt van wat de boodschap is van de politiek-correcte zombies:

De algoritmes hebben geen regels die daarin gestopt zijn door mensen, maar leren het zichzelf - in dit geval: wat de kenmerken zijn van mensen die frauderen. Heel simpel: je neemt een stapel mensen die betrapt zijn op frauderen, en haalt daar de gemeenschappelijke kenmerken uit:

Dan vis je met die kenmerken er nog een stapel uit, en kijk hoeveel ervan frauderen ten opzichte van een willekeurige greep. En als de gefilterde groep minder is dan de willekeurige, pas je het filter de ene kant op aan, en als je filter beter functioneert dan de willekeur, de andere kant:

Net zo lang tot het filter optimaal functioneert. En dat filter pas je toe op de praktijk.

En dan krijg je dit:

En dit:

Oftewel: de algoritmes ontdekten dat de aanwijzende factoren, de risicofactoren, voor fraude zijn (onder andere) alleenstaand moederschap en buitenlandse afkomst (die algoritmes hebben geen oren, en kunnen het slecht beheersen van de Nederlandse taal alleen afleiden uit de hen opgegeven woorden, en dat zijn administratieve gegevens, en daaronder dus dingen die leiden naar een buitenlandse afkomst). En dit:

Oftewel: dit algoritme heeft ontdekt dat een belangrijke factor bij het voorkomen van fraude is dat de studenten een buitenlandse afkomst hebben en bij familie wonen. Dat laatste is weer alleen een administratief gegeven want het algoritme gaat niet langs de deur, dus het is: volgens opgave bij familie wonen. De fraude zit erin dat ze bij die familie natuurlijk geen huur betalen, terwijl de extra toeslag bedoeld is voor het financieren van de dure huur van een kamer. Dat niet-betalen van huur blijkt weer uit de belastingaangifte van de betrokken familie. Kortom: deze detectie is sterk waterdicht. De combinatie van ervaringen met algoritmes leidende tot de conclusie: fraude zit in sterke mate bij mensen met een buitenlandse afkomst. Allochtonen, natuurlijk. Maar het aanwijzen van een slechte eigenschap bij allochtonen is hoogst verboden, want dat brengt de zegenrijkheid van migratie in gevaar, dus krijg je dit ...

... : een terreurcampagne in de media. Die het ontdekken van fraude door allochtonen heeft omgevormd tot ...

... , waarin de bestuurlijke elite volledig mee is gegaan ...

... en gaat. Waarin de student, op zoek naar zijn aantrekkelijke parasitaire baantje ...

... volledig meegaat, ondanks het feit dat hij donders goed weet:

... dat de algoritmes uitstekend werken, want wat hier staat is een soort pleonasme: je lijkt per definitie op je groep waar je in zit, en dat vergelijken is dus 100 procent proportioneel. Het 'íets misdaan hebben' slaat op individuen en niet op de groep. En dat hij weet dat hij liegt, blijkt ten overvloede ook nog eens uit dit:

... want 'kwetsbare groepen 'is één van de overbekende eufemismes voor allochtonen, oftewel mensen uit niet-westerse culturen van de soort "sterk achtergebleven", en die culturen zijn sterk achterblijvend onder andere door de sterke aanwezigheid van fraude in alle soorten en maten in die culturen Hartelijk dank voor deze gedetailleerde uitleg van het proces. De stroom heeft nu het niveau "politieke-correctheid" bereikt, oftewel niet meer bij te benen. Hier weer eens een greep, ten eerste omdat het een "deskundige" is (de Volkskrant, 22-07-2023, door Laurens Verhagen):

Op zich een goede aanpak. Het resultaat:

Inderdaad. Daar zijn die programma's voor bedoeld want daarop zijn ze getrained. Woordjes rijgen.

Wat we zeiden: getraind in woordjes rijgen.

Het bedrijf OpenAI is van Sam Altman en Sam Altman is Joods en Joden mogen liegen

Wat samengevat werd in de kop:

Wat vooralsnog onzin is: ook deze AI-stap kijkt alleen naar of de woordjes goed geregen zijn of niet. Dat is geen intelligentie. Hetgeen was wat de aandacht trok. Maar dit ...

... klopt dan weer wel. Hè, hè, eindelijk iemand die openlijk durft aan te geven waar het allemaal om draait. Nog niet ronduit te zeggen, maar wel aan te geven. En een buitenstaander, natuurlijk (de Volkskrant., 08-08-2023, column door Erdal Balci):

De parasitaire soort elite die klaagt dat productieven naar productie betaald willen worden voor hun werk oftewel de inzet van hun leven(-stijd).

Slaande op de klachten richting de ontwikkelaars van AI.

Klopt.

Klopt.

Bingo! Hier draait het om:

Dus niet per se 'de hoogopgeleide bovenlaag' maar de pratende hoogopgeleide bovenlaag. De "tijdens corona niet essentieel gebleken hoogopgeleide bovenlaag". De "laptop-thuiswerkers bovenlaag". De "bullshit-banen" bovenlaag. De alfa-intellectuele bovenlaag Dit soort lieden:

De media-vullende bovenlaag. Overbodige vraag: Snapt u nu waarom ze bij de media zo tegen AI zijn? Net zoals ze voor immigratie zijn want daarmee wordt de arbeid van de producerende goedkoper en blijft er meer geld over voor hen. Natuurlijk is auteur Balci ook zo'n figuur, want hij heeft de klok horen luiden maar weet toch echt niet goed waar de klepel hangt:

Dat gaat nog steeds over "domme" mechanische dingen.

Idem, en zelfs ook al bij mensen. Dit draait om mechanische presisie.

Dit zou dan weer over AI moeten gaan en het antwoord luidt: nee. Gaat niet gebeuren (iets met empathie).

Waar? Onzin.

Is niet onmogelijk maar nog vrij ver weg.

Volgt niet uit het direct voorgaan, maar is wel waar. Volgende alinea:

Onzin, de media staan er bol van. Zie boven.

Waarbij je je kan afvragen of die kunstenaar dan wel creatief is want de AI is het zeker niet.

Klopt, maar dat is, het staat er, reproductie dus geen creativiteit.

Hetzelfde nog een paar keer zeggen met andere woorden ... Dat is dus iets dat AI wel kan. Volgende alinea:

Nee, zo is het niet, of nog niet. De directe aanleiding voor deze column is dit:

Dit gaat niet over 'de superrijken', maar over Sam Altman, een Joods iemand die superrijk wil worden met behulp van AI. AI is stapje voor stapje ontwikkeld door mensen die daar normaal voor betaald werden en voor een groot deel zelfs uit technologische nieuwsgierigheid. Wetenschappers. Sam Altman is als eerste naar buiten gekomen als iemand die het wil gebruiken als verdienmodel. Zoals al eerder gebeurd is met Larry Page en Sergey Brin (Google, Joods), Mark Zuckerberg (Facebook, Joods), Richard Ellison (databases, Joods), enzovoort. Allemaal gebruikten ze in openbare gemeenschap ontwikkelde technieken om steenrijk mee te worden. Eerst nog even Balci afwerken:

Eerst maar wat sciencefiction lezen, dus, want daar is dat allemaal al besproken. Praten we daarna verder. En één van de dingen die daar langskomen, bij Isaac Asimov (ook Joods - het zijn niet allemaal graaiers) is het idee dat AI (voornamelijk) in handen komt van één enkel bedrijf. Wat er dus bestreden moet worden is niet AI, maar mensen als Sam Altman. Het grote gevaar van AI is mensen als Sam Altman. Die geen enkel middel schuwt (de Volkskrant., 04-08-2023, door Frank Rensen):

Oftewel: voor 15 euro wordt je gelokt je te laten absorberen als zombie van de Borg. Want natuurlijk werkt dit op precies dezelfde manier als je eerste hulpdienstje voor de drugsmaffia: daarna hebben ze je in de klauwen. En tegenover zoiets als een basisinkomen kan natuurlijk slechts je hele leven staan. Je eindigt als terrorist in dienst van de Altman-maffia. Die inmiddels allianties heeft gesloten met de Page&Brin- en Zuckerberg-maffia's. En dit ... :

... heeft natuurlijk precies dezelfde waarde als "Morgen is alles gratis". Overigens is ook dit allemaal al beschreven in de sciencefiction. Het bestrijden van de Sam Altman's dreigt een absolute noodzaak voor het overleven van de beschaving te worden. GeenStijl is de bron van de "... dat doen ze zelf veel beter"-grap, naar aanleiding van klachten over Russische berichten in de sociale media die moslims in een kwaad daglicht zouden zetten (toen er weer eens een aanslag gepleegd was of zo). De grap van GS: "Russen hoeven echt niet de moslims zwart te maken, dat doen ze zelf veel beter". De "humoristen" van de Volkskrant geven een loepzuivere voorzet voor iets dergelijks, in de vorm geheten "ironie" (de Volkskrant, 02-11-2023, rubriek De Speld, door Michel Doodeman):

De rubriek De Speld heeft enigszins een reputatie gekreen, in dat als er iets absurds gebeurt, met wel eraan wil refereren met termeninologie als "... en dat is niet iets van De Speld". En die gaan nu iets schrijven over AI, wat meteen laat zien hoe absurd veel aandacht het onderwerp heeft gekregen:

Ziet u ... En natuurlijk hebben ze het van GeenStijl, want dat spellen ze ook, allemaal.

En die mensen die daar zo ontzettend goed in zijn ... Die zitten echt niet in één of andere AI-computer farm, maar werken doodgewoon bij de Volkskrant ... Voor alle zekerheid: natuurlijk is dit de definitieve doodsteek voor alle AI-complottheorieën van die Volkskrant-terroristen. Er heeft al twee weken niet in de Volkskrant gestaan dat de wereld ten onder gaat door algoritmes, dus ... (de Volkskrant, 20-01-2024):

... , en natuurlijk weer van druiloor Laurens Verhagen. En de dag na het weekeinde (de Volkskrant, 22-01-2024):

De stoomlokomotief algoritme kan ieder moment de wei in springen om de koeien op te vreten!!! En ook uw geest! (de Volkskrant, 22-01-2024, door Danny Mekic, jurist en managementwetenschapper en ondernemer. Hij promoveert aan de Universiteit Leiden):

Jahaaaa, want, zoals algemeen bekend, hebben computersystemen veel meer onberedeneerde vooroordelen dan mensen dat hebben. Mensen zijn altijd veel objectiever in hun oordeel dan machines. Zie je machines, uh algoritmes, nog wel eens een zwarte uit de Schipholrij plukken omdat die uit Afrika komt zodat die machine denkt: "Dat zal wel een asielzoeker wezen", zal je dat een mens nooit en te nimmer zien doen. Het is maar goed dat de Universiteit Leiden vooruitstrevende mensen de gelegenheid geeft om op dit soort uiterst waardevolle observaties te promoveren. ... Wat een uiterst vermoeiende lui, zeg ... En dan ineens dat uiterst merkwaardige en zeldzame verschijnsel ... (de Volkskrant, 01-02-2024, rubriek De wetenschapper beziet de wereld, door Casper Albers, hoogleraar statistiek aan de Rijksuniversiteit Groningen.):

... : iets zinnigs in de Volkskrant over een politiek-correct gevoelig onderwerp. En het mag zelfs ...

... in de kop. Het risico zijnde ...

... de manipulatie door politiek-correcten en andere opportunisten die oog hebben voor slechts één belang: het eigenbelang (en dat van de eigen groep) Zelfs de hier allang gegeven uitleg staat er:

Dat laatste is misschen weer wat overdrijving maar het zou wel waar kunnen worden. Dat is het mooie van nieuwe technologische ontwikkelingen. En tevens wordt in dit artikel een ander mysterie opgelost, namelijk het mysterie van hoe lang er zulke rotzooi in gremia als de Volkskrant kan verschijnen ... :

... : als je de lijn van de politiek-correcten niet trekt, wordt je van de media gegooid. De vorige columns van Albers stonden vol met politieke-corrrectheid Er is op zijn minst een handvol laatste columns dat hetzelfde verschijnsel vertoont. Alleen al in de Volkskrant. De algoritmes en AI hebben hun eerste hele grote, maatschappelijk relevante, succes geboekt. Zo groot, dat de politieke-correctheid het volledig over het hoofd ziet (de Volkskrant, 26-02-2024, door Laurens Verhagen):

Net als de de reclamewereld, BBC met hun historische series, de producers van James Bond ... Oh nee, de laatste nog niet ondanks diverse proefballonnen. Van reclames op YouTube heeft deze redactie in korte tijd al ruim honderd neger-exemplaren verzameld, en zelfs in geregisseerde filmpjes over wetenschap en techniek kom je ze in overdaad tegen. En natuurlijk doet Google procies hetzelfde. Alleen komt dat normaal nooit uit. Het kan natuurlijk altijd een simpelere programmeerfout zijn, een kommaatje verschoven, maar sabotage is niet uitgesloten. Anyway, the cat is out of the bag, om in de taal van het beroep te blijven. Ze manipuleren de werkelijkheid ten gunste van de zwarten. Net als de reclameboys, de BBC, en de filmwereld dat doet. Maar nu moet het in programmertaal staan, en die is gewoon leesbaar, in tegestelling tot de breinen van al die genoemde lieden. Dus kom maar op met je algoritmes, om te bewijzen dat je de boel niet manipuleert. Of eigenlijk laat maar zitten, want dat bewijs hebben we dus al. Deze redactie zag het bericht al een aantal dagen terug op de website (Volkskrant.nl, 23-02-2024):

... , en toen het de volgende dag niet in de krant stond, dacht "Ze zullen wel zo slim zijn dit niet verder te publiceren". Niet, dus. Er is dus nog hoop voor de toekomst, als de vijand zo stom is. P.S. Ook geinig: die vrouw erbij ... P.P.S.S. Ze geven het gewoon toe:

En ze geven nog wat toe, hoewel ook zij, zogenaamd "slim", dat niet beseffen:

Waar dus zonder omhaal uit volgt (blanke nazi's zijn terecht, volgens hen, dus blanke topmannen ook) dat dit ...

... dus een gore leugen is: die blanke nazis zijn de werkelijkheid en de blanke topmannen zijn dus ook de werkelijkheid - het algoritme weet absoluut niet wat het verschil is tussen een nazi en een topman. Net als dit ...

... dus de werkelijkheid is. Ook hier te vinden ...

Oftewel: "Die mensen maken zich druk om niks dat Google politiek-correct en wokistisch manipuleert en fraudeert".

Oftewel: "Om tegen de tegen politiek-correcte en wokistische manipulatie en fraude van Google te zijn, moet je extreem-rechts zijn". Die Laurens Verhagen gaat van de rij "Tribunaal" naar de rij richting Feestplein. Mensen die de manipulatie en vervalsing van de maatschappelijk informatievoorziening promoten behoren tot het gevaarlijkste soort bureaumisdadigers. En daar heb je weer eens dat o zo zeldzame verschijnsel: zinnigheid: in de Volkskrant. En inderdaad: bij de ingezonden brieven (de Volkskrant, 07-03-2024, ingezonden brief van Fons Kleinveld, Boxmeer):

Op naar het volgende hetze-artikel van Debiel Verhagen. De Volkskrant heeft een rationeel besluit genomen ... (de Volkskrant, 26-04-2024, rubriek De week in tech, door Laurens Verhagen):

... : het heeft de betaalde persoon 'Laurens Verhagen' vervangen door een gratis te gebruiken AI-algoritme genaamd "Laurens Verhagen". De Volkskrant is zo vriendelijk geweest een bewijs te leveren van de drie hoofdstellingen rond het gebruik van algoritmes in het fraude-onderzoek. De eerste (de Volkskrant, 23-05-2024, door Dylan van Bekkum):

Oftewel: het algoritme vond factoren die niets te maken hadden met andere specifieke kenmerken dan studietype en woonafstand. En uit die factoren kwam de tweede stelling naar voren:

En uit de berichtgeving eromheen de derde:

En van deze stelling staat er ook het bewijs:

'Indirecte discriminatie' is het klappen van één hand: discrimineren is het handelen van mensen op basis van ongeldige factoren van de soort, geslacht, religie, etnie, en er hebben geen mensen gehandeld, en de factoren waren geldig. Dus bewezen zijn: - Algoritmes discrimineren niet. - Allochtonen frauderen extra. - Blanken krijgen de schuld van de allochtone fraude van de media en elite. Allemaal brandstof voor zowel de etnische En misschien beseft men dat ook wel ergens, want er werd een tweede uitleg door een "expert" noodzakelijk gevonden (de Volkskrant, 24-05-2024, door Charlotte Huisman):

En we zijn echt zo ontzettend benieuwd naar hoe je dat doet en hoe dat anders is dan werd gedaan. En dat laatste moet hij weten, want ... :

... hij heeft zelf het oordeel geveld. Aan de slag. Hoe werd het gedaan?

Dat wisten we al. Wat nog meer? We gaan niet het hele artikel reproduceren, maar neem maar van deze redactie aan: niets! Want dat kan je ook afleiden uit de opsomming van de oorzaken waarom het "fout" is gegaan:

Het is wonderbaarlijk op hoeveel manieren je hetzelfde kan zeggen. En van de Informatieregels Met op een gegeven moment zelfs een punt waar voorbij je kan stellen dat dan het tegenovergstelde waarschijnlijker is. We hebben hier een stuk of tien herhalingen. Waarbij je dan denkt: dat is voorbij dat punt. Waar het allemaal op neerkomt, is dit: je mag geen fraude onderzoeken, als het fraude betreft die meer voorkomt bij allochtonen. Oh ja: ook nog even het aantal eufemismes daarvoor tellen:

Valt nog mee: vijf soorten en negen uitingen. Zo, de fouten uitgeduid hebbende dan de vraag wat we er aan gaan doen. Of beter

Gaan we er wat aan doen? Is er een alternatief? Oh ja: gewoon een willekeurige steekproef. "Agent controleert oma met rollator op verboden wapenbezit". Tja, verboden wapenbezit bij oma's is met rollator natuurlijk heel gevaarlijk, want als de oma overvallen wordt zou ze dat wapen wel eens kunnen gaan gebruiken, en dat heeft het ongewenste neveneffect dat ze allochtonen verwondt want 99 procent van de overvallen op blanke oma's wordt gepleegd door allochtonen. En dus moet je oma's met rollator controleren op verboden wapenbezit vanwege dat ongewenste neveneffect dat het allochtonen benadeelt. Grapje? Nee hoor:

Oftewel: je mag niet selecteren op leeftijd, want dat heeft het ongewenste effect dat het allochtone jongeren benadeelt, en je mag niet selecteren op protserig automobiel, want dat heeft het ongewenste effect dat het allochtone jongeren benadeelt. In feite is dus alle fraude- en criminaliteitsonderzoek discrminerend, want in zo'n beetje alle fraudes en vormen van criminaliteit zijn allochtonen dominant. "En zo zouden we nog uren door kunnen gaan" (cit. FdJ). Ach zo, er komt een basaal aapje

O ja? Mogelijkheid 1: AI vertaalt slecht. Dan gaat niemand AI-vertaalde boeken kopen en is AI niet dodelijk. Mogelijkheid 2: AI vertaalt goed. Dan is AI niet dodelijk maar juist goed voor de vertaalde literatuur. Beide mogelijkheden kloppen niet met de stelling. Wat logisch gezien wel klopt, is dit:

Mogelijkheid 1: AI vertaalt slecht. Dan gaat niemand AI-vertaalde boeken kopen en verandert er niets voor de literatuurvertaler. Mogelijkheid 2: AI vertaalt goed. Dan is AI dodelijk voor de vertaalde literatuurvertaler. En de tweede mogelijkheid klopt met de stelling. En dat wordt zelfs ook toegegeven:

Dit is dus waar het om gaat. Dat is bij de overige bezwaren natuurlijk ook een belangrijke factor, maar hier is het dus de primaire. En dit ... :

... is dus van het niveau dat de snelheid van AI de passagiers de adem zal ontnemen, en de koeien in de wei zure melk zal doen geven. Oh nee, dat was voor de stoomlokomotief. En het mocht weer wat kosten ... (de Volkskrant, 08-06-2024):

Op naar de volgende technologische rampspoed ... Een kleintje maar we hebben hem nodig voor het vervolg (de Volkskrant, 14-06-2024, door Jonathan Witteman):

Dat was natuurlijk niet 'de bank' in de zin van een personeelslid dat dit besluit had genomen, maar een een simpel stukje software dat woorden in de beschrijivng van de transacties opzoekt in een database van verdachte woorden, zeg maar "bom" en "Osama bin Laden". Niets aan de hand. De bank vraagt om een toelichting:

Je lacht even, voldoet aan het verzoek, en ieder gaat zijns weegs. Niet bij moslims ...

En:

Niet geschikt voor het leven is een beschaafde, gereguleerde, samenleving, dit soort mensen. Te hoog op de kameel gezeten om daarin te kunnen functioneren. Maar we snappen het wel ... Minderwaardigheidscomplex. Niet te verhelpen, want ze zíjn minderwaardig Dus. En de Volkskrant gaat weer aan de slag met haar Münchhausen-by-proxy

Enzovoort, en dat alles ... (de Volkskrant, 14-06-2024):

... op een prominente plek en over een hele pagina. Waanzin, dus, maar waanzin trekt waanzinnigen (de Volkskrant, 17-06-2024, hoofdredactioneel commentaar, door Pieter Klok):

'Hoog tijd '... De Volkskrant doet sinds het ontstaan van AI niets anders dan 'de zwaktes van kunstmatige intelligentie onder ogen ... zien'. Zoals met ...

... , en, natuurlijk, ...

... , want dat was het voor de samenleving meest kostbare geval Miljarden verdwenen zo in allochtone zakken. En dat is natuurlijk zo fout als het maar kan, allochtoon wangedrag aan de oppervlakte brengen:

Geinig, dat 'ie dat als eerste zin zo opschrijft, zonder te beseffen wat 'ie daar opschrijft. Vrijwel iedere jacht op fraude zal tegenwoordig uitmonden in discriminatie, omdat allochtonen, net als meer overlast En dat noemt de politieke-correctheid dan "discriminatie": "Turken en Marokkanen armer dan Nederland:ers: discriminatie!" "Turkije en Marokko armer dan Nederland: discriminatie!" En de waanzinnige raaskalt voort:

U leest dit op een computer, die, zoals u weet, ook vooroordelen heeft. Zo heeft die computer soms ook een hekel aan u, en u reageert dan soms zo:

Althans: als u iemand bent als P. Klok die machines emoties toedicht. Net zo gestoord, dat is. En voor dat soort storingen geldt dat ...

... en wat je dan ook bijna altijd ziet is:

... dat ze zichzelf tegenspreken. Want dit is precies wat dit DUO onderzoek deed: het zocht naar studenten die opgaven uithuizig te wonen, en dicht bij de instelling woonden. Maar dat noem je dan "indirecte discriminatie". Om tenslotte te besluiten met een laatste uitbarsting van waanzin ten top:

Want er is bij computers sprake noch van intelligentie, noch van geweten. Bij P. Klok is er ook sprake van geen intelligentie, maar wel van emoties. Oneindig veel emoties. Die emoties zijnde van de soort die je tegenkomt in kathedraal, moskee en synagoge: totaal brein-overmeesterend. Je gaat geloven in Stenen Tafelen, Brandende Bosjes, Zoutpilaren en Kindoffers. Zijn specifieke exemplaren zijnde de Stenen Tafel van de Vrije Migratie, de Zoutpilaar die van De Gelijkheid der Culturen, het Brandende bosje dat van het redelijke denken, en het Kindoffer dat van iedereen die tegen voorgaande ingaat. Het bewijs wordt geleverd in één enkele frase in de aanhef van de preek:

Het is ongelofelijk. "Alweer een spookrijder! En weer eentje! En nog eentje!" Maar ook hiervan kennen we wel de achtergrond, hoor: P. Klok weet innerlijk net zo goed als u en ik dat moslims achterlijk zijn. Hij en de zijnen weten het namelijk prima van christenen Maar dat verdrukt 'ie allemaal in zijn geestje. Vandaar al die uitingen van absurdisme. En de campagne gaat onverdroten door. Er valt helemaal niets te melden, maar hier ... (de Volkskrant, 02-07-2024):

... zijn weer twee pagina's terreur afkomstig van de burelen van de misdadige organisatie genaamd de Volkskrant. En er staat weer precies hetzelfde ... (de Volkskrant, 02-07-2024, door Frank Rensen):

Correct: er zijn honderden zo niet duizenden mbo-opleidingen, en mbo'ers hebben dus altijd een opleiding dicht bij huis bij de hand. Universiteiten zijn er slechts twee dozijn, en ook nogal gespecialiseerd.

Aleid Wolfsen is iemand die in het verleden heeft bewezen een stompzinnige sneuneus te zijn (iets met de politiek), en baantjes krijgt via het bestuurlijke sneuneuzencircuit.

Net weer eens uitgelegd: er zijn voor elke fraude risicofactoren die niets met discriminatie te maken hebben. Dat was één van de twee concrete voorbeelden. Het tweede is nieuw in deze discussie, maar verhelderend:

Wat doet denken aan een komische scène meer dan twintig jaar geleden, waarin een politieman de resultaten van een vliegtochtje met een infraroodcamera boven de stad te berde bracht - op dat soort opnames zie je twee dingen opvallen, naast elektriciteitscentrales: kassen, en wietkwekerijen. "De randen van de stad, waar de kampers wonen, lichtten op alsof ze in brand stonden", verhaalde de politieman. "Su ondusoeku ons", was de reactie van een kampbewoonster. Paul Witteman kreeg de zaken niet aan elkaar gebreid. Tja, fraudeonderzoek leidt naar allochtonen en dergelijke en is dus inderdaad per definitie discriminerend. Dus dat was weer eens zeer verhelederend: er zijn speciale groepen in de samenleving die een risico vormen voor fraude, en de twee genoemde gevallen zijn allochtone immigranten dus rondtrekkers, en rondtrekkers. Als je dan een speciale sympathie hebt voor rondtrekkers (Joden zijn ook rondtrekkers zo niet dé), dan ben je dus tegen de detectie van fraude. Dus tegen algoritmes die fraude detecteren. En we zijn weer thuis. En negen dagen later en ten nogmaals bewijze dat dit een volledige obsessie is (de Volkskrant, 11-07-2024):

Een bezorgde moeder schrijft de Volkskrant (de Volkskrant, 11-07-2024, door Hanske Douwenga):

Mispoes! Hier zijn de volledige credentials van de auteur:

Oftewel: activistische alfa-intellectueel Met vermoedelijk een onbewuste instinctieve afkeer van alles dat riekt naar techniek en rationaliteit in het algemeen, wnat dat hebben ze bijna allemaal. Zie de start van de aansluitende alinea:

Wat gevuld wordt door zenuwzieke alfa-intellectuelen en welks lezersbestand bijna uitsluitend bestaat uit zenuwzieke bèta-hatende alfa-intellectuelen, en boordevol staat met ...

... zenuwzieke Joodse alfa-intellectuelen ...

... wiens zenuwzieke product we al besproken hadden, in de verzameling Internet afkeer

Om heel precies te zijn: dit gaat allemaal volledig en uitsluitend over meisjes. Jongens spelen buiten wie het hardst kan lopen/steppen/fietsen, meisjes spelen buiten wie vriendinnetje mag zijn met wie. En kijk 'r eens, aansluitend verder met de activiste:

En dat gaat allemaal om een zo goed mogelijke man te kunnen krijgen die zo goed mogelijk voor de kinderen kan zorgen. Vandaar ook die niet te stoppen voorkeur voor rijke en machtige mannen. En dan gaan klagen over de techniek ... Beheers eerst eens je hormonen, truttebollen!!! Overigens, bedacht naar aanleiding van dit verhaal: er is maar één verbod nodig om hierop een bijzonder sterke rem te zetten, effetiever dan alle andere verboden en regulering: Verbiedt reclames!!! Want het gaat die sociale mediabedrijven allemaal om geld, en dat komt niet van de gebruikers, maar van de reclames van voornamelijk de grote internationale bedrijven en concerns. Maar daar zullen ze van lang zal ze leven niet opkomen, bijvoorbeeld bij de Volkskrant, want daar leven ze zelf van. Zeg eens dat dit niet totaal obsessief dus gestoord is ... Want de volgende dag (de Volkskrant, 12-07-2024):

En het niets anders dan pure herhaling - ten bewijze het hele artikel (de Volkskrant, 12-07-2024, door Joris Krijger):

En dat het niet alleen preken voor eigen parochie maar ook preken voor eigen portemonnee is, staat er ook nog doodgewoon:

Oftewel: "Meer, meer, meer centjes voor mij". Over bullshit jobs gesproken ... En binnenkort in dit theater: "Wiskunde is een zienswijze, net als rekenen". Dit dan natuurlijk nadat het "gedekolonialiseerd" is Eentje van een maand of twee terug, maar met een goede reden (de Volkskrant, 04-05-2024, door Laurens Verhagen en Margriet Oostveen):